目录

Ollama本地大模型 + webui + 个人知识库

windows

步骤一.

win + R打开命令行:

shellstart https://ollama.com/download/OllamaSetup.exe

安装ollama

步骤二

检查安装:

shellollama -v

步骤三:

下载模型:

shellstart https://ollama.com/library

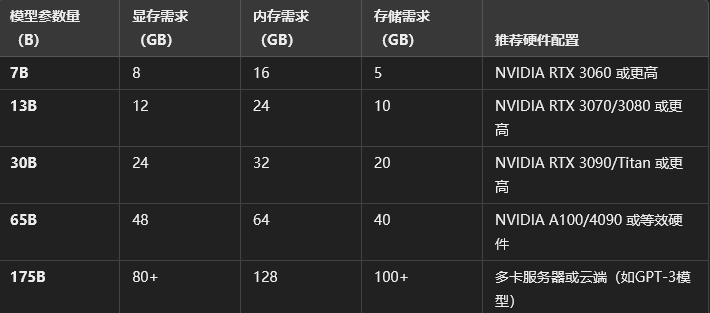

选择适合模型:

[!NOTE]

[!TIP]

推荐的几个模型

通用任务:

- mixtral:8x7b-instruct-v0.1-q5_1

- nous-hermes2-mixtral:8x7b-dpo-q5_K_M

角色扮演:

- silicon-maid:7b-q5_k_m

embedding:

- nomic-embed-text

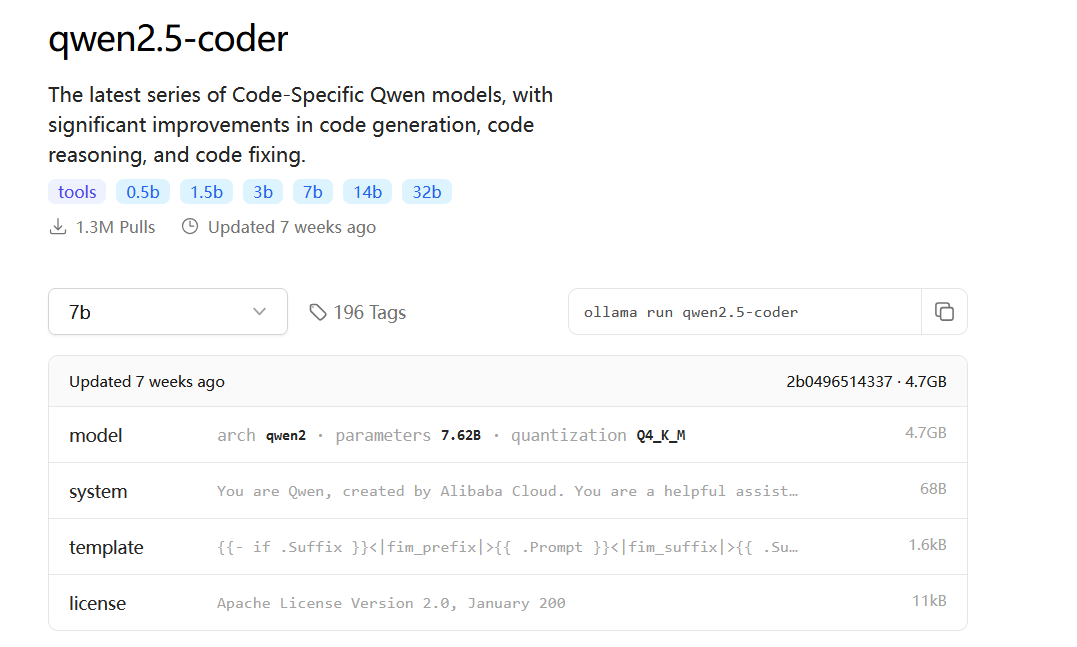

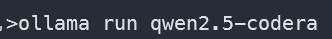

我们以aliyun的通义千问为例:

我这里选择擅长编码的模型,参数量选择7b(选择适合自己的)。复制后面的命令,在cmd中执行。

安装完成之后,即可运行。

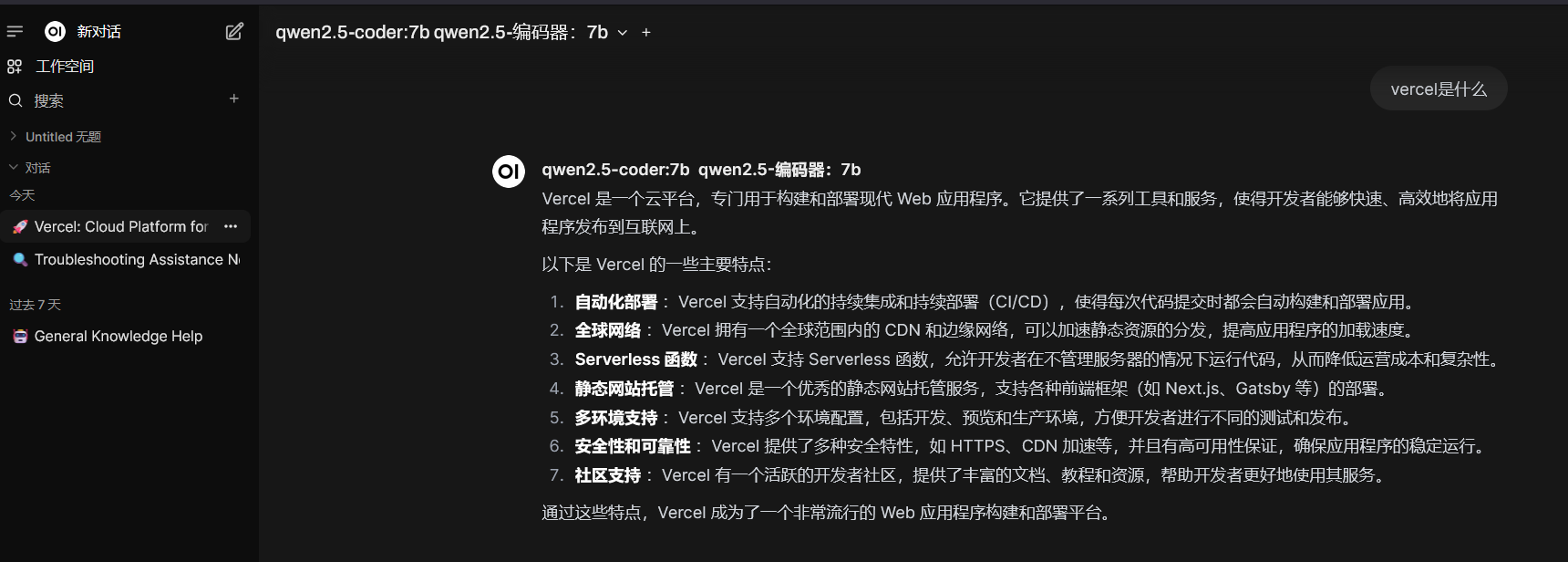

Web ui部署

eg:

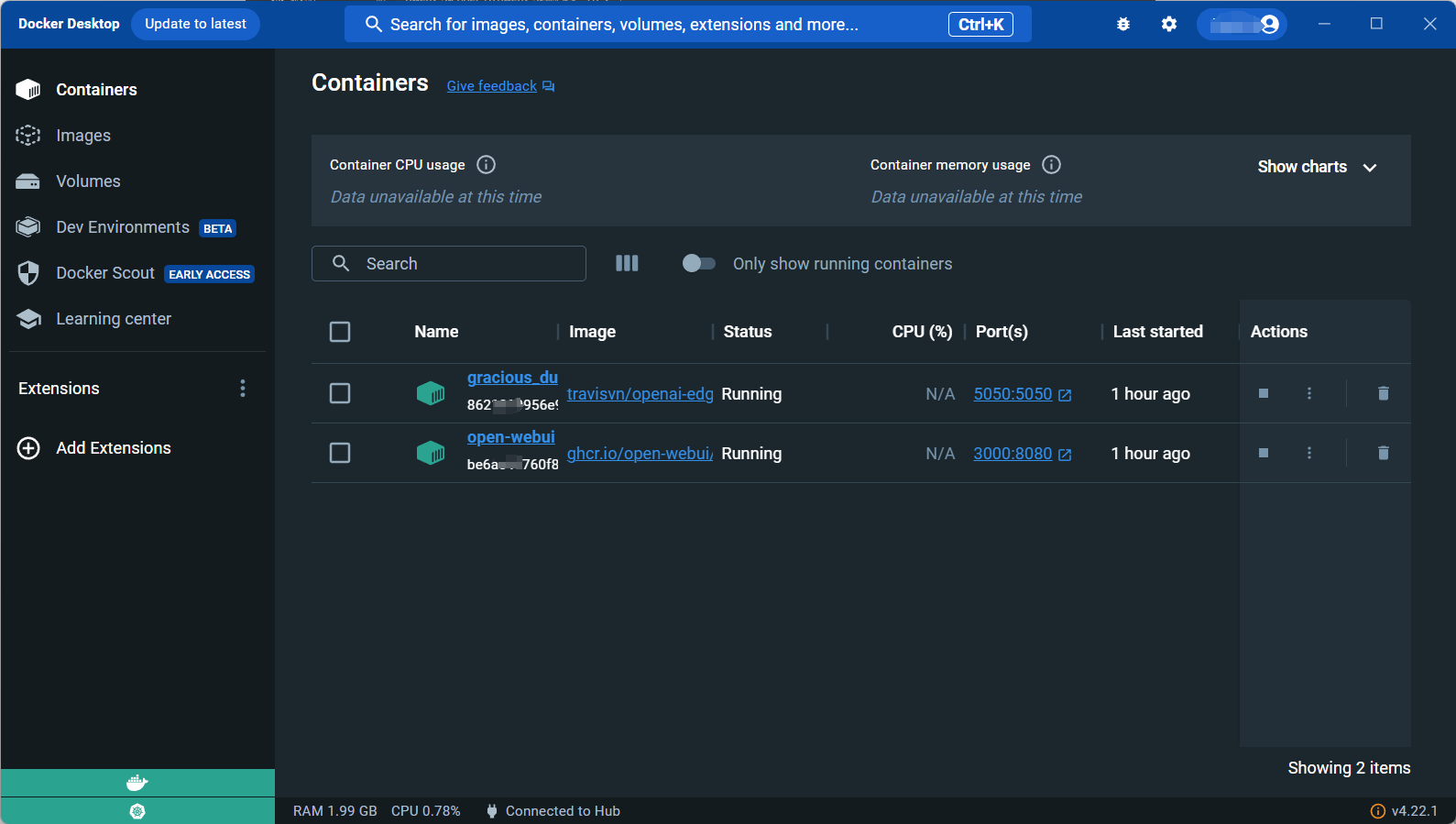

首先我们需要安装docker(我选择安装docker desktop)

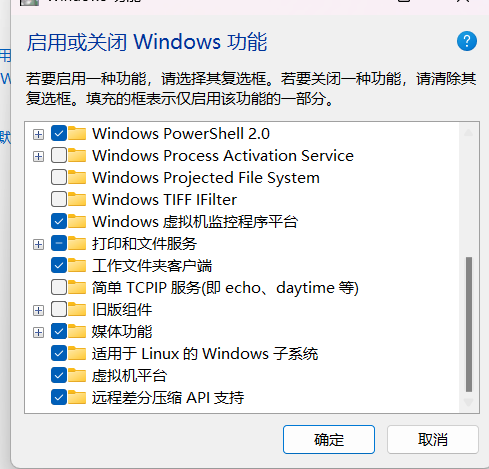

我们需要在设置中将虚拟化打开以支持docker(注意如果电脑有安装mumu模拟器之类的可能会有冲突)。

开启虚拟化

控制面板 ->程序 -> 启用或关闭Windows功能 -> 虚拟机和适用于Linux的Windows子系统

无法安装可以网盘,@我。

使用webui打开ollama

本机ollama:

shelldocker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

使用GPU(nvidia):

shelldocker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

打开http://localhost:3000,以访问webui。

构建个人知识库

我这里选择ollama平台加Langchain-Chatchat构建个人知识库大模型。

首先给出官方文档我选择的是本地pip部署:

pip安装

[!NOTE]

强烈建议先在想要部署该项目的根目录添加python venv虚拟环境,防止pip包版本冲突。

python -m venv <the_name_of_venv_you_want>创建完成后,会多出一个目录名字你定。

然后我们尝试激活该虚拟环境

Windows

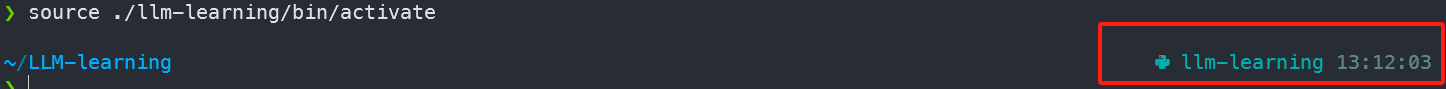

.\<the_name_of_venv_you_want>\Scripts\activateLinux/macOS

source ./<the_name_of_venv_you_want>/bin/activate看到下图所示即为激活成功:

windows:

linux:

然后我们就可以在该虚拟环境下安装包了。

shellpip install langchain-chatchat -U

如果下载速度慢或者是无法下载:

尝试换源;

shellpip install <package-name> -i https://pypi.tuna.tsinghua.edu.cn/simple

安装推理框架模型

开头已经安装ollama,其他框架如xinference,请查看对应官方文档。

初始化项目配置与数据目录

1.设置 Chatchat 存储配置文件和数据文件的根目录(可选)

shell# on linux or macos

export CHATCHAT_ROOT=/path/to/chatchat_data

# on windows

set CHATCHAT_ROOT=/path/to/chatchat_data

2.执行初始化

shellchatchat init

3.修改配置文件:

初始化完成后,目录下会多出几个配置文件,我们需要对其中几个作出必要的配置:

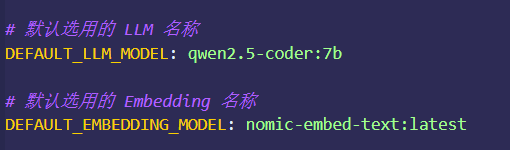

改为自己的模型。

emdedding是嵌入模型,可在ollama上下载。

然后其他保持不变(有想法可自行配置)

将MODEL_PLATFORMS除ollama外注释,修改为如下

shellplatform_name: ollama platform_type: ollama api_base_url: http://127.0.0.1:11434/v1 api_key: EMPTY api_proxy: '' api_concurrencies: 5 auto_detect_model: false llm_models: - qwen2.5-coder:7b embed_models: - nomic-embed-text:latest text2image_models: [] image2text_models: [] rerank_models: [] speech2text_models: [] text2speech_models: []

模型名称根据自己下载的来。

不知道的使用

shellollama list

查看。

4.配置知识库路径:(可选)

默认知识库位于 CHATCHAT_ROOT/data/knowledge_base,如果你想把知识库放在不同的位置,或者想连接现有的知识库,可以在这里修改对应目录即可。

# 知识库默认存储路径 KB_ROOT_PATH: D:\chatchat-test\data\knowledge_base # 数据库默认存储路径。如果使用sqlite,可以直接修改DB_ROOT_PATH;如果使用其它数据库,请直接修改SQLALCHEMY_DATABASE_URI。 DB_ROOT_PATH: D:\chatchat-test\data\knowledge_base\info.db # 知识库信息数据库连接URI SQLALCHEMY_DATABASE_URI: sqlite:///D:\chatchat-test\data\knowledge_base\info.db

不建议C盘。

初始化知识库

shellchatchat kb -r

初始化前一定确保有embedding模型。

成功日志:

shell---------------------------------------------------------------------------------------------------- 知识库名称 :samples 知识库类型 :faiss 向量模型: :bge-large-zh-v1.5 知识库路径 :/root/anaconda3/envs/chatchat/lib/python3.11/site-packages/chatchat/data/knowledge_base/samples 文件总数量 :47 入库文件数 :42 知识条目数 :740 用时 :0:02:29.701002 ---------------------------------------------------------------------------------------------------- 总计用时 :0:02:33.414425

启动:

shellchatchat start -a

弹出界面:

即可。

然后即可在GUI中配置自己的知识库。

本文作者:Hyrink

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!